Aspectos Legais da Segurança

na Informática e no Comércio Eletrônico

Mesa Redonda de Abertura do 2o. Simpósio de Segurança

na Informática

Instituto Tecnológico da Aeronáutica,

S. J. dos Campos SP, 24/10/2000

Departamento de Ciência da Computação

Universidade de Brasilia

O prisioneiro ela levado ao topo da pirâmide, seu peito era aberto com uma faca cerimonial e seu coração era arrancado vivo, colocado ainda pulsando neste vaso. Não fica claro o porquê, mas o fato é que este vaso foi substituído depois pelo seguinte na seqüência. Este segundo era maior, do tamanho de uma bacia, e suponho que podia receber uns dez corações pulsando ao mesmo tempo. Parece que o alto clero teria determinado a troca dos vasos, pela necessidade de mais sacrifícios, deduzida de alguma escassez.

A cena ia ganhando dramaticidade, porque este segundo vaso foi substituido por um maior, e este por um outro gigantesco, do tamanho de uma piscina redonda de jardim. A canaleta para correr o sangue neste último vaso era parecida com a bica de um monjolo. A pirâmide do sol dos aztecas havia sofrido sucessivas expansões para poder receber mais gente em seu topo durante os rituais. O pensamento de tentar adivinhar quantos corações pulsantes eram arrancados para encher aquela maior me deixou estarrecido, mas o terror que me marcou para sempre eu senti quando tentei imaginar a lógica daquele processo.

Os aztecas sacrificavam apenas prisioneiros de guerra. Alguma escassez passageira deve te-los convencido de que sua segurança estava em se manterem num permanente estado de guerra, conquistando povos, para poder suprir as necessidades imprevisíveis do deus sol com a maior eficácia possível. Num estalo de horror perguntei a mimi mesmo se, durante todo aquele tempo, nenhum azteca teria percebido que os esforços de guerra e de crescentes conquistas iam deslocando a linha que separa a escassez da fartura, e que aquela escalada sanguinolenta levava a um beco sem saída? Esta é uma constatação muito óbvia para ter escapado a um povo tão industrioso e formidável. Fiquei então com a desconfortável sensação de que talvez sim, eles viram esse fato, mas o tomaram como inevitável e natural. Não lhes poderia ocorrer que havia algo de errado com o dogma por trás de tudo.

Dogma é isso. Mito, é a religião do outro. E eu fiquei paralisado ao entender o poder do dogma.

Me lembrei disso tudo porque precisava dizer para vocês, em quinze minutos, o que eu penso sobre nossas leis e a segurança na informática. Parece que quanto mais o mundo investe em segurança na informática, pior fica o cenário dos riscos e a sofisticação das fraudes e embustes, conforme costatam os especialistas em internet reunidos esta semana em Berlim para discutir o assunto (veja http://www2.uol.com.br/info/ aberto/infonews/102000/24102000-14.shl). E o que fazemos? A maioria se ocupa em tentar acompanhar e entender o que está acontecendo, mas tem gente na linha de frente tomando iniciativas.

E o que se ouve do front? A mim me parece que estou ouvindo um coro quase uníssono, clamando por leis mais severas para coibir os crimes digitais, por mais proteção e estímulo a quem investe em tecnologia, por mais investimentos, regulamentos, e iniciativas para garantir a segurança no ciberespaço, pois nele penetra cada vez mais nossa realidade. Alguém ainda disputa a importância dos mercados financeiros no mundo globalizado?

O professor é pago para pensar, e feliz do professor que goza a sua liberdade para escolher em que pensar. O que vejo no cenário da segurança na informática me inquieta. Assim, senti-me atraído a refletir sobre a razão desta inquietude. Nelson Rodrigues dizia que toda unanimidade é burra, e o cenário da segurança talvez me inquiete por eu estar inferindo que a quase unanimidade é quase burra. Devo então procurar pela quase burrice no lugar comum da segurança dos bits.

Um lugar comum que logo observo é o seguinte. Apesar das leis sobre informática serem recentes, já apresentam um vício curioso. Quando se quer atingir um objetivo com determinada lei de informática, o mecanismo para atingí-lo traz consigo, via de regra, efeitos indesejados ou imprevistos cuja gravidade e conseqüências não são abordadas durante o debate legislativo. Sempre há pressa em aprova-las, já que a evolução da tecnologia pode torná-las obsoletas antes que entrem em vigor.

Uma estratégia muito em voga para atacar essas dificuldades postula que as leis de informática devem ser neutras em relação à tecnologia, para evitar engessá-la. A tendência começou nos EUA com o DMCA, e ganhou força total com a lei e-Sign, aprovada por mais de 400 votos contra 4, uma quase unanimidade. Mas o que normalmente se consegue legislando sobre tecnologia da informação sem mencionar tecnologia, é o efeito bode. Os objetivos escapam, e fica-se com os efeitos imprevistos e indesejados. Quando a poeira começa a abaixar surgem dúvidas sobre a intenção do legislador, ou melhor, do lobby sobre o legislador.

Estas dúvidas ficam ainda mais inquietantes quando nos damos conta da sinergia possível entre os efeitos colaterais dessas leis combinadas. Em particular as três leis da informática mais importantes, aprovadas nos EUA nos últimos dois anos: o DMCA, o e-Sign e o UCITA. Elas me fazem lembrar a experiência azteca. Sem querer ser alarmista com esta comparação, quero dizer que, a julgar pelos sintomas, pode ser que estejamos presos a dogmas cuja utilidade está chegando ao fim.

Vejamos o caso do DMCA. O processo de replicação de representações simbólicas vem ganhando eficácia com a tecnologia, desde a invenção da imprensa no início da renascença. Com Hollywood na Internet a situação ficou crítica, pois os produtores de obras caríssimas precisam controlar a pirataria. O que fazer? O controle de cópias se dá a nivel físico, e não sintático. A internet não pode ser controlada a nivel físico. A solução foi dar ao controle de acesso sintático, cuja função é isolar conteúdos semânticos, o título de tecnologia antipirataria. Assim, a cifragem foi emoldurada no DMCA como mecanismo de proteção contra cópia. O efeito prático foi a introdução do direito do distribuidor de conteúdo para controlar acesso, sob o pretexto de ter que controlar cópias, que permanecem incontroláveis, numa lei que pretende ser milenar.

Já o E-Sign é uma obra prima de neutralidade tecnológica. Outorga às partes o direito de substituir, em contratos eletrônicos, a assinatura de próprio punho por qualquer mecanismo de autenticação digital aceito pelas partes contratantes. Mas quem são as partes, os mecanismos e os contratos em questão? Os contratos apresentam, além das responsabilidades que listam, riscos opostos para as partes, na forma de possíveis fraudes e repúdios de má fé. Os mecanismos de autenticação digital não podem se valer da jurisprudência tradicional sobre contratos para equilibrar esses riscos e responsabilidades, devido à sua natureza e características técnicas. Dentre os mecanismos possíveis, os que usam biométrica colocam todos os riscos no lado de quem precisa se autenticar, enquanto os que mais se aproximam do equilíbrio de riscos e responsabilidades da jurisprudência tradicional, os que usam criptografia assimétrica, não podem alcançá-lo no todo. Já as partes contratantes estarão quase sempre separadas por várias ordens de grandeza no poder de barganha para negociarem entre si esse equilíbrio, a cada substituição da caneta, voluntária ou não. O cidadão e o monopólio são exemplos.

Para regular os processos sociais, anteriores à internet, nos quais os mecanismos desequilibram riscos, tais como o trânsito, o comércio de alimentos e de armas, leis foram criadas buscando o equilíbrio de riscos e responsabilidades entre as partes. Essas leis contrapõem para isso liberdades e "engessamentos". Para mim ainda não está claro porque a filosofia tem que ser diferente na esfera virtual, ou se estamos vivendo a ficção de Orwell, em que nos são oferecidas justificativas em novilíngua.

Já a UCITA surge como pedra de toque para completar este quadro. Trata-se de uma proposta para uniformizar as leis estaduais que regulam o comércio em transações e processos informacionais nos EUA. Surgiu porque a constituição do país atribui aos estados o poder de regular o comércio, o que é ineficiente na esfera virtual. Sob o pretexto da necessidade de uniformização, novos desequilíbrios são introduzidos. Em seu modelo de negócio para o software há um truque para proteger o produtor dos códigos de defesa do consumidor. A licença de uso do software passa a ser um contrato particular de prestação de serviço. Legitima-se as licenças exibidas na tela no ato da instalação do software, com as costumeiras cláusulas aberrantes e outras ainda mais draconianas. Neutraliza-se outros mecanismos de defesa do licenciado ao estabelecer como foro jurídico do contrato o estado do produtor onde vigora a UCITA.

Segundo juristas que o criticam, a UCITA criminaliza a engenharia reversa, a comparação de performance e a divulgação de falhas ou engodos nas promessas de funcionalidade do software. (veja http://www.cnn.com/2000/TECH/computing/ 03/07/ucita.idg/index.html). Consente explícitamente que o produtor instale gatilhos para implosão remota no software, para o caso de suspeitas de quebra do contrato pelo licenciado, no qual o produtor é isento de toda responsabilidade por disparos acidentais ou maliciosos. Conta com forte lobby de grandes empresas e com o repúdio de todas as entidades jurídicas e organismos de defesa do consumidor que já a examinaram. Está em debate ou tramitação em 48 estados americanos, e foi aprovada nos dois onde já foi votada. São 350 páginas de hermetíssimo legalês, que me fazem pensar na piscina de pedra azteca com sua bica. Este grande esforço legislativo americano está me parecendo uma corrida pela fartura através de um beco sem saída.

Não é preciso muita imaginação para antever o que pode ocorrer com a sinergia dessas três leis. Eu peço que me respondam o seguinte. Você comeria sardinhas se na lata em que vierem, ao invés da estampa do serviço de inspeção do Ministério da Agricultura, estiver impresso um disclaimer dizendo que, ao abrir a lata, você assume qualquer risco pelos efeitos daquele conteúdo no seu trato digestivo, eximindo o produtor de qualquer responsabilidade por danos causados pela ingestão? A França e a China levam isso a sério e já aprovaram ou estão debatendo leis que buscam neutralizar este poder, privilegiando o software livre. O Município do Recife também. A França tem fortes suspeitas da ação desse poder em casos de espionagem industrial que vitimaram suas indústrias.

No final dos anos 70, a IBM pagou caro pela sua relutância em perceber que uma fase na evolução da informática estava chegando ao fim, com a desagregação do modelo de controle sobre arquiteturas de hardware. Como ocorreu no nível dos circuitos, é possivel que tenhamos outra mudança, desta vez no modelo de controle sobre arquiteturas de software. A internet é uma experiência com padrões abertos, sobre a qual agora se luta em torno de dogmas. Acredito que qualquer reflexão séria sobre o tema desta palestra, no momento que atravessamos, deve identificar e rever a utilidade dos vários dogmas que nos movem, e que agora se chocam no ciberespaço, onde se enxergam uns aos outros como aberrações monstruosas.

Ver também "confiança",

"software

livre". Ver abaixo a palestra proferida em seguida nesse mesmo congresso

Internet e Outras Redes

Risco nas Tecnologias e Modelos

Palestra no 2o. Simpósio de Segurança

na Informática

Instituto Tecnológico da Aeronáutica,

S. J. dos Campos SP, 25/10/2000

Departamento de Ciência da Computação

Universidade de Brasilia

Agradeço ao prof. Clovis Fernandes por este convite. Sinto-me honrado em participar do único evento nacional de escopo acadêmico em segurança computacional de que tenho conhecimento.

Enfoque

Segurança em informática é um quebra-cabeça. Nesta palestra pretendo oferecer um roteiro para entendermos o que surge deste quebra-cabeça, baseado em observação holística do cenário onde esta segurança é tematizada e discutida. Por isso escolhi falar sobre risco, cujo conceito nos permite uma visão panorâmica da sua montagem. Para isso, buscaremos sintetizar o inusitado e o peculiar no cenário da informática, e as estratégias com que nele interagirmos. Nessa busca, dois modelos sociais se destacam por estarem em predominância e seguindo trajetórias de colisão. O conhecimento da dinâmica e evolução dos modelos negociais e jurídicos na informática é crucial para este entendimento.

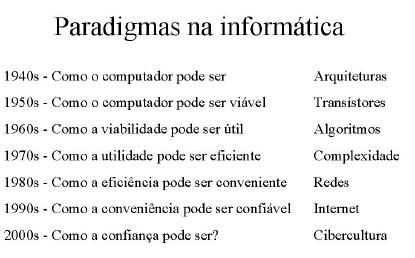

Transparência 1: Paradigmas da informática

Metáforas

Para iniciar esta busca, proponho a abordagem Kuhniana para explicar a evolução da computação em paradigmas. Um paradigma é uma metáfora para organizar o entendimento, que se forma em torno do desafio central à ciência no momento. Precisamos de metáforas para entender o desconhecido, e a informática vem renovando seus paradigmas com rapidez inusitada. Em consequência, acompanha-se sua evolução com metáforas quase sempre defasadas em relação àquela que o cientista precisa para promover esta evolução, dificultando a comunicação entre uns e outros.

Redes fechadas e abertas

Para entendermos os riscos afetos à virtualização dos processos sociais, é essencial compreendermos a mudança de paradigma ocorrida com o advento da Internet. A Internet é uma rede de redes autônomas, de hierarquia aberta, a primeira do gênero. Uma rede fechada e autônoma reflete alguma hierarquia social do mundo da vida, que determina o propósito e a conduta de seus agentes e que pode ser controlada por seu dono, através de contratos sociais e da infra-estrutura de comunicação que a realiza.

Já a Internet foi arquitetada para não ter dono. O dono de uma rede autônoma a ela conectada pode tentar controlar o tráfego que entra e sai de sua rede, mas nada além disso. Em palestras para leigos me esforço muito para explicar esta diferença.

O verdadeiro bug do milênio

Mecanismos de autenticação e controle para redes autônomas fechadas não terão o mesmo efeito na Internet. A única forma de controle nela possível é exercido nas pontas, pois o propósito e a natureza da ação de interlocutores só pode ser efetivamente estabelecida nessas pontas.

A Internet é mais parecida com uma cooperativa de comunicação do que com uma rede mundial de computadores. Confundi-la com uma rede fechada e autônoma é, como diz Edgardo Gerk, fundador do meta certificate group, o verdadeiro bug do milênio. A Internet surge como uma nova etapa da revolução da informação, numa oitava acima da galáxia de Gutemberg na escala virtual do fenômeno humano.

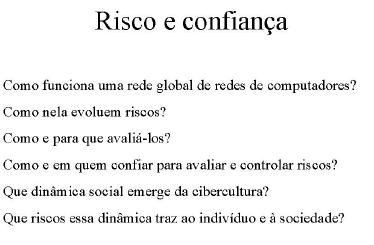

Cibercultura

Qual seria então a questão central a desafiar a tecnologia da informação nesta década? Professores são pagos para pensar, e isso nos dá o direito de especular. Se seguirmos o encadeamento das questões centrais que imagino terem desafiado a ciência da computação, podemos inferir que é a questão da confiança. Estamos iniciando um novo ciclo, onde nossa ciência precisa agora lidar com um conceito que ainda não sabe aquilatar.

O que é confiança?

Vocês já tentaram definir confiança? Ao tentarem, verão como é difícil evitar a circularidade. Se definimos confiança em termos de crença, logo temos que definir crença, que é melhor explicada em termos de confiança. Não sabemos sequer se é mensurável. A melhor aproximação que conheço é esta: confiança é o processo pelo qual se obtém significado da informação. Em lingüística, seria o mecanismo que controla a semiose. E quanto ao risco?

O que é risco?

Identificar e avaliar riscos pode ser algo subjetivo, como quer o poeta Fernando Pessoa no verso "tudo vale a pena, quando a alma não é pequena". Ou algo objetivo, como querem os atuários ao defini-lo como Perda multiplicada por Probabilidade. Podemos combinar estes dois pontos de vista e descrever risco como uma métrica para decisões que envolvem confiança.

O demônio de Descartes

Nos anos 70, segurança na informática significava imaginar que computadores e programas eram feitos por Murphey. Backups, nobreaks, extintores de incêndio, já que Murphey dizia que o que pode dar errado vai dar errado. Murphey era um otimista. Ele supunha que saberíamos dizer o que pode dar errado. Hoje, com o fio azul ligando o mundo, esta segurança significa imaginar que, por trás da tela, está não só Murphey, mas também o demônio de Descartes.

O risco metafísico

Descartes queria promover um novo método, para inaugurar a ciência moderna. Para isso precisava separar conhecimento de crença, mas evitando o risco de ir para a fogueira promovida pelo monopólio de ambos na época. Especulou então que o mundo talvez não fosse exatamente como o percebemos, se um demônio muito esperto estivesse manipulando nossa percepção, com esse intuito.

E se estiver, não temos como sabê-lo. Descartes postulou assim o risco metafísico. Quando começamos a compreender perfis de risco na informática, eles já estão mudando junto com seu paradigma. Para avaliarmos riscos na nuvem promíscua de elétrons que é o mundo virtual, temos que conhecer as intenções, as falhas e as limitações dos programas com os quais interagimos, e o efeito de sua exploração nos comportamentos humanos. Delegar esta tarefa a mais um software é empacar em paradigmas obsoletos. As respostas às perguntas sobre a relação entre risco e confiança aqui listadas precisam ser buscadas na ordem correta, terminando numa crucial questão social: Como e a quem delegar esta tarefa? Usuários comuns não são especialistas, e precisam confiar em algo ou em alguém para dar sentido ao virtual que nos fecha o cerco. Afinal, haverá algo mais virtual do que o valor do dinheiro?

Controle da execução

O paradigma imaginado aqui para a cibercultura é muito parecido com o postulado por Descartes. Ele argumentou que não devemos confiar de graça nem nos nossos cinco sentidos. Estamos numa situação parecida, pois precisamos distinguir cadeias de bits que podem ser programas, para termos algum controle sobre sua execução. E quando executam, precisamos saber o que acontece por trás da interface enquanto interagem, por desígnio ou por semântica espúria. Para isso antivírus e firewalls ajudam, mas eles são também, e apenas, programas.

Na cibercultura a última decisão deve ser nossa, se quisermos administrar nossos riscos. O vírus ILoveYou se espalhou daquele jeito porque o Outlook Express decide por todos quando os VBscripts que chegam anexados a mensagens serão interpretados, contrariando RFCs do IETF sobre o formato MIME. Para avaliarmos riscos, precisamos aquilatar a qualidade do software, mas a qualidade segundo a óptica isenta de quem precisa neles confiar.

Lógica de programas

Em código de máquina, a lógica de um programa está quase opaca ao homem. Em código fonte bem escrito, um programador experiente terá acesso a ela, como também algum controle sobre o que incluir ou modificar na versão a compilar. Quanto mais simples for essa lógica, maior a chance de que falhas de qualquer natureza possam ser detectadas em boa hora.

Este acesso em software proprietário é bloqueado sob o argumento da segurança do negócio em torno dele. Já a possibilidade deste acesso é a idéia que move o software livre. Livre quer dizer com liberdade, onde a gratuidade é apenas uma possível liberdade. A industria do software proprietário age como se a segurança na informática fosse o mesmo que a segurança do seu negócio, e alguns acadêmicos até fazem eco, como o prof. Silvio Meira em sua coluna no Jornal da Tarde.

Para entendermos o quebra-cabeça da segurança, precisamos observar seu processo a partir de um referencial integrador, holista. Precisamos ver que a segurança do negócio, a da funcionalidade e a do usuário do software são distintas e freqüentemente conflitantes.

Acreditar que quanto mais dinheiro ganhar o dono do programa, melhor será sua lógica para o usuário, é ilusão posta pelo demônio de Descartes, pois tal crença supõe, na teoria econômica em voga, um mercado perfeito, e o mercado de software está longe da perfeição, e se diantanciando. Como gosta de repetir Fernado Nery da Módulo, a segurança é uma corrente tão forte quanto seu elo mais fraco.

Intenções e falhas

Nossa busca começa na observação de que a informação existe e é transmitida em três níveis: o físico, o sintático e o semântico. E de que riscos podem se materializar em incidentes nesses distintos níveis. Temos aqui uma das possíveis classificações e nomenclatura das suas manifestações em nível sintático, guiada pelos mecanismos de proteção hoje oferecidos pela criptografia.

Mas a associação entre riscos e mecanismos de proteção não é simples. Observamos que distintos níveis de limitações, falhas e intenções espúrias podem interagir em sinergia. Um bloqueio de serviços que não deixa rastro, por exemplo, se compõe de etapas onde os outros tipos de ataque ocorrem antes.

Intenções e riscos

A Internet foi arquitetada para permitir a comunicação global por qualquer rota possível. Para o contexto então em foco, a guerra fria, a intenção era legítima. Buscava-se a confiança na possibilidade da comunicação. Mas seu sucesso permite hoje ataques distribuídos que bloqueiam serviços, pois onde houver comunicação pode haver barulho. No contexto atual, com o comércio eletrônico, isso constitui séria vulnerabilidade pois tais ataques são praticamente inevitáveis.

Diante da possibilidade da comunicação, queremos agora confiar na sua qualidade. A evolução do contexto mudou o valor daquela intenção, transformando uma proteção a nível físico numa vulnerabilidade a nível sintático. Além disso, alguns riscos só se manifestam onde a criptografia é inócua, no nível semântico, como aqueles que surgem através do abuso de poder.

Administração de riscos

Não podemos portanto associar diretamente riscos e mecanismos sintáticos de proteção, como parecem querer certos vendedores de softwares de segurança. A verdadeira segurança é o processo de se administrar a materialização de riscos. Não é o de se eliminar, terceirizar, ocultar, ou coisa que o valha, porque qualquer ação neste sentido irá gerar outros riscos. "Garantir segurança" é apenas uma figura de retórica que propõe a aceitação de algum perfil de exposição a riscos. Como a política, a segurança é uma arte de escolhas.

Identificação

A primeira tarefa da segurança funcional é a identificação. Estamos de novo com Descartes pois os bits, não tendo fisionomia, caligrafia, timbre, cheiro ou cor, quando encadeados carregam significados que programas e circuitos atribuem segundo algum acordo prévio, a sua semântica. Se esses bits intermediam interações sociais reguladas por leis, a identificação do responsável por sua produção ou manipulação é essencial para a eficácia dessas leis.

O canal de comunicação

Como programas não têm vontade própria, ao interagirem haverá pessoas tomando decisões, que precisam ser identificadas onde o contexto exige. O mecanismo mais simples para isso é copiado do mundo da vida e arremeda a guarda medieval, que no portão do castelo pede a quem quiser entrar para que sussurre a senha.

O sussurro de uma senha pessoal pelo fio do teclado identifica o canal de comunicação entre seu portador e o ambiente computacional onde tal senha dará direitos de acesso. Alguns querem só os direitos, e insistem para ficar em paradigmas passados. Boicotam a identificação no controle de acesso, permitindo o compartilhamento de senhas para evitar responsabilidades e expandir direitos, justificando a esperteza como desburocratização e agilidade.

Numa rede fechada esse boicote pode ser administrado, como também a intimidade do fio do teclado estendida, por meio de protocolos como o Kerberos. Mas numa rede aberta tais controles perdem a eficácia e a proteção ao sussurro torna-se mais complicada.

Alguns afirmam que a identificação biométrica é a salvação, mas nossa busca irá mostrar que a ilusão de segurança nesta proposta é perigosa, pois se baseia em paradigma obsoleto. Para explicar as limitações da biométrica, proponho deduzirmos a especificação da criptografia assimétrica a partir das premissas de autenticação postas pela rede aberta, na próxima transparência.

O alcance da mensagem

Numa rede fechada, chaves para cifragem podem ser simétricas. Mas numa rede aberta, temos que fazer chegar uma chave ao interlocutor pretendido e saber que o segredo da cifra só estará com quem de direito. Precisarmos sussurrar em público, no escuro. Este é o famoso problema da distribuição de chaves, posto na rede aberta. Sua solução depende de cifras assimétricas, onde uma das chaves possa trafegar às claras sem com isso comprometer o segredo da sua inversa.

O valor da mensagem

A distribuição de chaves de cifragem não completa a busca por mecanismos de proteção numa rede aberta. Para que as mensagens encriptadas tenham valor, precisamos de protocolos que neutralizem ataques de replay e espelhamento. Os agentes numa rede aberta podem precisar saber quando as mensagens recebidas são replicadas de eventos anteriores.

A circulação do valor

O pior estrago que o demônio de Descartes pode causar aqui é fazer o leigo crer que a mídia magnética é para o documento eletrônico, o que o papel é para o documento tradicional. Por não ser, a autenticação digital precisa criar um autenticador binário único para cada documento, que remeta à sua origem no mundo da vida através de verificação.

Se a autenticação se destina a substituir a assinatura de punho na espécie jurídica do contrato, e o princípio da analogia for mantido nessa nova jurisprudência, a etapa de verificação tem que ser aberta a terceiros. A verificação aberta só poderá se dar por meio da criptografia assimétrica, como veremos. Outrossim, o nome do titular das chaves precisa ser autêntico para a eficácia do protocolo, já que o valor de um documento depende da confiança com que a verificação de assinaturas identifica seus autores.

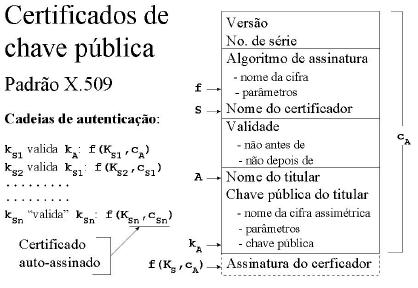

Uma outra chave é então necessária para autenticar a chave que verifica a assinatura, que por sua vez também precisa ser autêntica. Temos aqui uma necessidade recursiva de autenticação com verificação aberta. Este processo recursivo foi chamado de certificação, e está hoje padronizado em PKIs.

.

Verificação de autenticadores

A autenticação digital é um protocolo criptográfico, entre agentes com seus distintos riscos e intenções. Um deles quer permitir a identificação da origem e integridade do que transmite, enquanto o outro quer obter esta identificação.

Nas situações em que a arbitragem por outros mecanismos pode resolver eventuais disputas e conflitos, protocolos simples bastam, nos quais a etapa de verificação pode repetir o cálculo do autenticador, cujo resultado é conferido com o recebido para decisão sobre integridade da cadeia de bits transmitida.

Se a verificação é restrita a quem para isso compartilha um segredo com o emissor, a lisura e a conduta cautelosa do verificador são pressupostos, como ocorre no uso de senha, quer seja ela tradicional, ocasional ou biométrica, pois a chave verificadora representa o próprio segredo que autentica.

Em situações nas quais quem autentica pode ser prejudicado por forjas perfeitas possibilitadas pelo protocolo, com ou sem a intenção do verificador, os protocolos no qual não entra segredo, ou entra compartilhado entre emissor e verificador, são impróprios e falhos. O tipo de autenticação para este caso terá que permitir a verificação aberta, para arbitragens, enquanto identifica origem e integridade do documento autenticado.

Padronizações

Podemos agora deduzir a necessidade da criptografia assimétrica a partir dessas premissas de autenticação. Para que a verificação possa ser aberta, o segredo para a autenticação deve separar-se do programa que a executa e alojar-se numa chave binária, pois sua posse dever ser única. O custo da obtenção desta chave a partir da chave verificadora, ou dos autenticadores que gera, deve estar sob o controle de quem gera o par de chaves, em termos de custo exponencial relativo ao tamanho do segredo.

Se o protocolo busca evitar que a verificação permita forjas, terá que evitar duas coisas. A verificação não poderá simplesmente repetir o cálculo do autenticador, como acontece no MAC ou em outros mecanismos baseados no compartilhamento de segredos, pois a chave de verificação serviria também para forja. Ela deverá portanto inverter esse cálculo, o que obriga o protocolo a usar uma codificação reversível, uma cifra. E nele a chave de verificação deve ser distinta da chave de autenticação a ponto de impedir sua dedução, como já observado.

Cifras assimétricas para verificação aberta

Estas premissas desenham precisamente a especificação do que é hoje conhecido como criptografia assimétrica. Seria natural chamar o protocolo autenticatório dela derivado de assinatura digital. Entretanto, temos também a contribuição cultural do marketing, criando novos usos para velhas palavras de forma a nelas maximizar a confusão semântica, para benefício de seus clientes. Assim, os interessados em escamotear riscos hoje chamam qualquer mecanismo autenticatório de assinatura eletrônica, e a biblioteca do congresso americano os corrobora.

Eles desejam novas leis que permitam ao mercado escolher mecanismos autenticatórios para substituir a assinatura de punho em contratos eletrônicos. Entretanto, no regime do UCITA isso eqüivale a pedir ao legislador que assine um cheque em branco, em nome de quem representa, dando confiança irrestrita ao implementador das plataformas de autenticação e à indústria que irá embuti-los em software, atores que já deram repetidas e alarmantes mostras da perigosa relação entre o alcance de seus interesses e a qualidade de seus produtos.

Caixa de Pandora

Mas a assinatura por chaves assimétricas poderá mesmo substituir a de punho sem atropelar a filosofia do Direito? A resposta honesta é: quase. E o que falta para o sim, está oculto em uma caixa de pandora, preparada pelo demônio de Descartes para os juristas do nosso tempo. Para vermos o que ela esconde de inusitado, vamos comparar a funcionalidade das duas assinaturas.

Ambas identificam a autoria do documento à qual se apõem, como também a integridade de seu conteúdo, desde o ato de assinatura. Queremo-las úteis para vincular vontade ou anuência do autor ao conteúdo do documento, se este for um contrato. Para isso, quando houver garantias sobre a titularidade de uma assinatura de punho, ou seja, uma razoável certeza de quem seja o autor de um registro de referência, tem-se que o reuso, forja, ou repúdio em má fé da assinatura deva estar contra o balanço de probabilidades para o código civil, ou fora da dúvida razoável para o código penal.

Sob as mesmas hipóteses, ou seja, de que a titularidade de uma chave no protocolo já esteja assegurada, podemos ver como a assinatura digital consegue alcançar as duas primeiras das exigências citadas. Mas quanto ao repúdio, entra em cena a peculiaridade do suporte material do documento eletrônico, que não é físico e sim um conjunto binário, para romper o equilíbrio na jurisprudência dos contratos, anteriormente buscado por meio do não-repúdio.

Não-repúdio

O não-repúdio é uma salvaguarda jurídica de um contratante contra possível má-fé do outro. Num contrato solene assinado em papel, exige-se testemunhas para amparo à nulidade de um repúdio. Em contratos comuns, registros de fé pública que titulem a assinatura bastam para dar suporte à perícia grafotécnica diante de repúdio, que poderá então produzir juízo sobre sua origem.

Um juiz dificilmente aceitaria o argumento de que o cerebelo do titular foi copiado para que a forja de sua assinatura fosse perfeita. Mas no caso digital, a chave privada pode ser copiada sem que o titular perceba, e forjas perfeitas daí produzidas. Por outro lado o titular poderá também alegar, em má fé, que sua chave privada foi comprometida, onde uma perícia técnica sobre a ocorrência de vazamento pode ser perfeitamente contaminada ou neutralizada, antes ou durante a perícia.

A importância do não-repúdio

A crença em duas premissas de autenticação por assinatura de punho estão na base da jurisprudência da espécie jurídica do contrato, essencial ao direito comercial. Daí a importância do equilíbrio jurídico nas disposições sobre imputabilidade e admissibilidade de repúdio desse tipo de assinatura.

Tomando-se o princípio da analogia para guiar a jurisprudência em novos cenários, devemos examinar as condições de crença em premissas análogas no contexto dos protocolos de autenticação digital. Vemos que as duas premissas da assinatura de punho se projetam em análogas para a criptografia assimétrica, mas sem o amparo das crenças que as sustentam no mundo da vida.

Analogia de premissas

A premissa de que o padrão de autoria de uma assinatura será reconhecível, é funcionalmente análoga à posse única da chave privada, ambas fortemente ligadas ao não-repúdio. A premissa de que haverá registro com titulação de fé pública acessível para verificação, é análoga à premissa de que o titular de uma chave pública poderá ser identificado. Esta segunda premissa tem sua crença amparada em protocolos de certificação, já padronizados e implementados por PKIs. Mas a primeira não tem nem amparo material, nem a devida atenção de juristas e legisladores do virtual. Nos vários eventos sobre direito e informática que já participei, nunca ouvi outro palestrante abordar seriamente questões legais relativas à proteção da chave privada. Dificuldades na aplicação do princípio da analogia e complexidades técnicas podem justificar esta desatenção, mas não a pressa com que se quer ordenar a prática do protocolo. Esta pressa está no decreto presidencial Nº 3.585, de 5/9/2000, determinando que a casa civil da Presidência, a partir de 2001, só deverá aceitar documentos em forma eletrônica, digitalmente assinados.

X.509

O modelo de certificado X.509 permite a implementação de protocolos abertos que autenticam e verificam chaves públicas em cadeia. Essas cadeias acabam inevitavelmente em um "ponto cego", cuja implementação mais simples aceita certificados auto-assinados para sua terminação. Isso não deve nos distrair do fato de que o significado de um certificado auto-assinado é apenas uma auto-proclamação de autenticidade. No SSL a vulnerabilidade desse ponto cego é tratada como oportunidade de negócio.

A Verisign iniciou suas operações como certificadora, assinando certificados de chave pública para quem quisesse tê-los e distribui-los, enquanto o navegador era distribuído contendo inicialmente o certificado auto-assinado da Verisign em seu chaveiro. Sempre que o navegador receber um certificado, irá verificar sua integridade usando os certificados que já estão no chaveiro, até uma falta ou uma auto-verificação. Neste procedimento, se um novo certificado recebido pelo navegador estiver auto-assinado será recusado, pois a chave para verificá-lo não estará no chaveiro, já que ele próprio a carrega.

Autoridades certificadoras

As autoridades certificadoras não ganharam este nome por concessão estatal para prestação de serviços públicos, e sim do marketing de seu modelo de negócio. A auto-atribuída autoridade se refere ao privilégio da distribuição de seu certificado auto-assinado no núcleo do chaveiro de um software para navegação, que tem como apelo permitir o acesso a uma infra-estrutura de chaves públicas na Internet. Este apelo é reforçado pelo fato das PKIs também darem solução ao problema da distribuição de chaves para cifragem em rede aberta.

As CAs oferecem algum suporte ao direito de repúdio dos seus clientes, mantendo listas de revogação de certificados e limitando seus prazos de validade, o que contribui para seu fluxo de caixa, mas também distrai o público do principal problema nos direitos de repúdio.

Falsa titularidade

Ouvem-se maravilhas do certificado digital. Dizem que garantem que o dono da chave é quem ele diz ser. Isto soa bem, mas é apenas figura de retórica do marketing de produtos e serviços em PKIs, e não deve ser levado a sério. Um certificado autenticado garante apenas que a chave e do nome de seu titular nele contidos são os mesmos apresentados à CA.

A identificação do titular da chave a partir do nome no certificado é uma questão semântica, de responsabilidade de quem for usá-lo. Numa rede fechada os riscos nesta identificação são bem mais tangíveis que numa rede aberta. Como pode um mero nome como "Encol" ou "Ikal" garantir ser o que diz ser, ontem, hoje, amanhã? Vocês acham que leis mais severas sobre marcas e patentes irão diminuir esses riscos na Internet, mais do que promover abusos econômicos e censura?

No primeiro passo dos protocolos de certificação surge o risco da falsidade ideológica, e no último surge o de fraude. As CAs se eximem da responsabilidade legal pela identificação civil do titular dos certificados que assina, seja ele pessoa física ou jurídica, como consta nas declarações que divulgam sobre o serviço que vendem. A primeira CA do Brasil, a Certisign, delega esta responsabilidade aos cartórios de notas e ofícios, e o decreto supracitado assim o exige.

Ambiente de assinatura hostil

A jurisprudência do repúdio e não-repúdio busca equilibrar riscos e responsabilidades entre as partes. Mas a arbitragem do repúdio de assinatura digital não é juridicamente análoga à de assinatura de punho, como busquei ilustrar. A admissibilidade de prova do vazamento involuntário da chave privada por software embusteiro no ambiente de assinatura é uma questão delicada, devido à tensão entre a ubiqüidade do código móvel no ciberespaço, onde embustes digitais podem apagar seus próprios rastros, e o fato de que esses rastros podem também ser perfeitamente forjados. Não se trata de mera prova material de roubo, pois no vazamento ninguém é privado da posse de nada.

Leis sobre o tema quase sempre responsabilizam o titular pela guarda de sua chave privada, sem dispor sobre admissibilidade e ônus da prova de conduta cautelosa. Caso sejam admissíveis, quem poderia ser responsabilizado por danos? Certamente os produtores dos softwares que animam o ambiente computacional onde a assinatura digital é produzida não poderiam, segundo os termos de suas licenças de uso. Mas tais licenças teriam valor legal inconteste, acima das leis de proteção ao consumidor? No regime do UCITA, terão.

E se as evidências levantarem suspeitas de que o próprio software do sistema é quem deliberadamente promove o embuste, como ocorrido em casos de espionagem industrial na França, envolvendo inclusive o SIVAM?. O UCITA tornará crime a busca e divulgação destas evidências.

E se as provas de cautela não forem admissíveis? O cenário para o titular fica ainda pior.

Ambiente de verificação hostil

Riscos na autenticação por chaves assimétricas não estão apenas no vazamento de chaves privadas, mas também no último passo da cadeia de verificação, a despeito do que digam os marqueteiros. Qualquer solução para o problema da terminação desta cadeia será um calcanhar de Aquiles no ambiente de verificação. No ponto cego do SSL, por exemplo, uma fraude no chaveiro do browser poderá plantar certificados auto-assinados que o farão verificar titularidades falsas de chaves com origem desconhecida.

Criptografia não é mágica. Ela apenas remaneja, através de operações sintáticas que manipulam probabilidades, os pontos, modos e momentos nos quais a confiança é presumida em comunicações humanas. A criptografia não pode gerar confiança a partir do nada. No paradigma da confiança, quanto menos se tiver que ocultar, melhor. Mas é muito difícil explicar isso a quem está enfeitiçado pelo mito da tecnologia como panacéia dos problemas humanos. Há que se vencer hábitos criados pela retórica que evoca a tecnologia como palavra mágica para reivindicar credibilidade, cujas vítimas tendem a desconfiar do princípio de Nemeth, o de que a segurança é o inverso da conveniência. Algumas delas estão encalhadas em paradigmas obsoletos e acham que quanto mais se puder ocultar, melhor. Acreditam na segurança através do obscurantismo, perpetuando suas mazelas.

Vazamento e revogação

Os protocolos de certificação só podem amparar uma das duas premissas de autenticação por assinatura, e parcialmente. Isto é pouco, e daí o argumento pela necessidade de novas leis para o comércio eletrônico. Quem se engajar numa PKI, por opção ou necessidade, deve aquilatar o perfil dos riscos a serem administrados, e portanto o que estará sendo de fato promovido por leis propostas ou em debate. O risco da obrigatoriedade, por exemplo, nos põe em níveis desconhecidos de exposição aos riscos já descritos.

A revogação de certificados de chave pública promove direitos mínimos de repudio, mas não o equilíbrio entre riscos para emissor e verificador. Os desequilíbrios começam no fato inusitado dos certificados digitais funcionarem por distribuição de cópias. Quem tiver uma, deve saber da revogação. O prazo de validade atenua esse problema, pela revogação automática na expiração do prazo. Mas a limitação de alcance da revogação não é o pior desses desequilíbrios, além do fato da revogação não sair barato.

O principal problema decorre de uma outra instabilidade: a revogação pressupõe que o titular suspeite de que sua chave privada tenha vazado. Mas essa suspeita surge normalmente pela constatação de uma forja, que será perfeita se anterior à revogação. Se o direito de repúdio for estendido a documentos com datas anteriores à da revogação da chave, o titular estará apto a refutar perfeitamente, em má-fé, contratos que assina.

Já a negação desta extensão implica em responsabilidade do titular pela pureza do ambiente computacional onde suas assinaturas são geradas. Mas este controle estará além das suas aptidões culturais, ou mesmo em conflito com sua licença de uso para os softwares que animam este ambiente. O software proprietário é um bem de terceiro, onde o bem não pode ser inspecionado e o terceiro não pode ser responsabilizado.

Nenhuma outra indústria em nossa civilização goza de tanta regalia antiregulatória, algo inusitado que colhemos para nosso roteiro. Você comeria sardinhas se na lata em que vierem, por exemplo, ao invés da estampa do serviço de inspeção do Ministério da Agricultura, estiver impresso um disclaimer, dizendo que ao abrir a lata você assume qualquer risco pelos efeitos daquele conteúdo no seu trato digestivo, eximindo o fabricante de qualquer responsabilidade por danos causados pela ingestão?

Evolução

Estamos diante da questão que postulo como paradigma para a próxima década, na necessidade de se proteger o processo computacional autenticatório. O caminho natural será o de se confinar este processo em algum hardware dedicado. Os cartões inteligentes estão se aproximando do limiar de performance necessária para este confinamento, e a dança dos riscos continua por aí, com a possibilidade de dedução da chave privada pela leitura externa de flutuações de consumo de energia do cartão durante a assinatura. Como a dança de Shiva, a dança da segurança também é eterna.

Transparência 13: Modelos de leis sobre autenticação eletrônica

Direitos de repúdio

Na lacuna digital entre revogação e repúdio, o demônio de Descartes insere um dilema, onde temos que optar entre legalizar a fraude ou impor a negligência, mantidas as jurisprudências e tendências atuais sobre modelos de negócio do software. Este dilema tem levado entidades interessadas na virtualização dos processos sociais a proporem medidas curiosas.

O nó górdio

Soluções ora Gordianas, ora Orwellianas são propostas, onde no impasse de um problema, muda-se o problema. Algumas ignoram solenemente os riscos aqui examinados e declaram que, para a autenticação eletrônica, não cabe o repúdio. Outras misturam alhos com bugalhos, embaralhando riscos para o emissor com riscos para o verificador, propondo a liberdade das partes em buscarem soluções mágicas no compartilhamento de segredo para autenticação. Isso numa rede aberta, onde o cenário de riscos e fraudes parece piorar quanto mais se investe para controlá-lo. É o verdadeiro bug do milênio.

Modelos de lei

Há basicamente três modelos de lei para regulamentar autenticadores eletrônicos, todos trazendo graves riscos sistêmicos. Há o modelo prescritivo, que legisla diretamente sobre o funcionamento de PKIs;

Há o modelo de critérios, que estabelece parâmetros de funcionalidade e confiabilidade, a serem alcançados por um mecanismo aceite como substituto da assinatura de punho; E há o modelo de outorga, que não estabelece métodos nem critérios, mas delega às partes o poder de decidir quais mecanismos serão para tal aceitos.

A primeira de tais leis sancionada no mundo, a do estado de Utah, segue o modelo prescritivo e impõe responsabilidade total pela guarda da chave privada ao seu titular, com os riscos já apontados. A da Califórnia segue o modelo de critérios, com o risco adicional de vestir mecanismos falhos com um véu de confiança infundada, já que não sabemos ainda como medir confiança em implementações e ambientes onde operam os protocolos.

A recem-promulgada lei federal dos EUA, a e-Sign, sobrepõe-se às leis estaduais e segue o modelo da outorga, adiconando àqueles o risco de abusos por agentes cujo poder econômico lhes permitam impor mecanismos que desequilibrem riscos e responsabilidades, e onde o equilíbrio destes deveria ser o objetivo da lei.

Qualquer desses riscos sistêmicos contribuirá para que as quadrilhas especializadas em crimes eletrônicos ampliem suas áreas de atuação além da indústria financeira. O prejuízo com este tipo de crime é hoje estimado por especialistas em cerca de 70 bilhões de dólares ao ano, pagos nas taxas de serviços financeiros. Enquanto fazemos coro em vilipêndio aos hackers, bandos engravatados se locupletam com sofisticação crescente manipulando a interface de confiança entre o homem e a tecnologia.

Transparência 14: Harmônicas da Revolução da Informação

Liberdade

Está claro que a poderosa indústria de software administra seus riscos seguindo as leis de mercado, empurrando-os para o cidadão sempre que possível, com os riscos daí decorrentes -- a infidelidade e rebeldia do consumidor -- administrados com propaganda, cartelização e inércia. Esta estratégia será bem sucedida enquanto acreditarmos que a liberdade do homem para decidir seus rumos deva subordinar-se à liberdade do capital para se reproduzir, permitindo a este ditar nossa conduta. Segundo Erich Fromm, o homem tem medo da sua liberdade, no que temos que concordar ao observarmos as preferencias coletivas, já que o homem hoje outorga irrestritas liberdades ao mercado, ao invés de assumir as responsabilidades sociais pela sua própria. Acha que assim terá segurança, mas sem saber até onde ou a que preço, enquanto vê os riscos nesta outorga com a mesma atitude com que olha para o lixo radioativo ou a degradação do meio ambiente.

Capital e poder

Se estivermos mesmo numa nova etapa da revolução da informação, temos muito a aprender com a história da renascença, surgida com a invenção da imprensa. Quando vemos a industria de tecnologia, comunicação, entretenimento e software mobilizarem o poder político para sancionar novas e draconianas leis, destinadas a coibir os novos graus de liberdade emanados dessa revolução que ameacem seus modelos de negócio, não podemos nos furtar à comparação entre o poder do capital de hoje e o da igreja de então.

Um desses graus de liberdade tem dado ao próprio capital o poder de solapar os mecanismos de controle que o estado sobre ele até então exercia, e vemo-lo agora imolando heresias e hereges, na frenética jogatina global onde se mercadeja o valor dos meios de produção e de troca. A própria teoria econômica que organiza o cassino, tida como ciência, é fruto desta liberdade, onde os alquimistas modernos experimentam seus modelos no cadinho das simulações computacionais, para competirem em precisão profetizante.

O risco metafísico nisso tudo está no fato das ciências se fundarem em algum dogma, que inclui pelo menos a crença no poder de seu método, enquanto dogmas envelhecem. E o dogma neoliberal da sabedoria suprema da mão invisível do mercado, que retroalimenta esse cadinho, pode ser a lenha com que estamos imolando as liberdades humanas, nas fogueiras da contra-reforma digital que se desenha. A escravidão foi apenas um passo na história da humanidade, ou seria cíclica e estaria voltando? Lembremo-nos de que toda argumentação a favor da escravidão sempre foi puramente econômica, como estão sendo os argumentos a favor das leis Orwellianas que buscam impor confiança na interface entre o homem e as tecnologias da informação.

A contra-reforma digital

Sinais da marcha desta nova contra-reforma se avolumam nos modelos jurídicos que orbitam o conceito de software. No caso das assinaturas digitais, podemos observar uma enorme pressão sobre o processo legislativo para que o ônus da prova de forja e da conduta cautelosa seja transferido para o acusado, revertendo-se uma tradição do Direito. (veja http://firstmonday.org/issues/ issue5_8/mccullagh/index.html)

O eminente professor de direito constitucional da Universidade de Harvard, Dr. Laurence Lessig, em seu brilhante e recém publicado livro, "Code, and Other Laws of Ciberspace", nos alerta sobre a ingenuidade e o perigo da crença de que não pode haver controle do ciberespaço. A liberdade da arquitetura TCP/IP, que faz da Internet o alicerce do ciberespaço, não impede que se erga sobre ela uma infra-estrutura de formatos e aplicativos proprietários para desenhar sua geografia, suas leis e regulações ex ante. Se quisermos preservar a liberdade do seu alicerce neste erguimento, precisamos lutar pelo que nele está em jogo: a liberdade humana.

Lessig nos alerta sobre o risco metafísico nesta marcha de conquista do ciberespaço pelo capital, que pode torná-lo muito mais controlador e opressor do que tem sido o mundo da vida, a partir do qual o comportamento humano poderá ser guiado e manipulado de formas ainda mais penetrantes do que imaginado por Orwell, em "1984", onde a arquitetura do software ditará as formas e os modos de interação social. O princípio da analogia, tão importante ao direito constitucional na tradição anglo-saxã, enfrenta na esfera virtual uma erosão inusitada, o que nos proíbe de nele depositarmos esperanças para que os consagrados princípios constitucionais da liberdade humana contrabalancem efeitos nefastos desta conquista.

Propriedade intelectual

Esta erosão está estampada na atual jurisprudência da propriedade intelectual, arma poderosa do capital para deter nesta marcha a "ameaça comunista", como a chamou Steve Balmer, materializada pelo modelo negocial do software livre. Em nossa busca, precisamos ver essas leis em sua evolução histórica. Elas não são lapidares e imutáveis leis naturais, como querem os que dela se utilizam como armas de poder. Só surgiram depois da invenção da imprensa, para equilibrar recompensas na produção intelectual. O trabalho de se copiar um manuscrito era em si, outrora, um trabalho honrado e digno de remuneração como serviço, que com o advento da tecnologia de impressão se tornou desproporcionalmente mais vantajoso e menos honroso que o do autor.

Mas com a Internet estas leis perderam o equilíbrio, pois o controle de sua aplicação no ciberespaço é pouco eficaz. Por outro lado, os ganhos com propriedade intelectual sob tais proteções se tornaram desproporcionais aos que eram, antes de serem estas estendidas ao novo produto intelectual, o software. Nunca antes, na história da humanidade, um empreendimento amealhou tanto dinheiro. Fica fácil explicar porque, se nos lembrarmos de que o direito de propriedade sobre o software não veio acompanhado de responsabilidades decorrentes, como em outras jurisprudências, uma peculiaridade importante no nosso quebra-cabeças.

Acesso à lógica

A forma eficaz de se administrar a propriedade intelectual na cibercultura é através do controle de acesso semântico, já que o controle sintático em larga escala é nela inviável. Portanto, as proteções ao direito de propriedade estendidas ao software são hoje administradas através de restrições de acesso à lógica de programas e formatos digitais. Em consequência, nos submetemos passivamente à intermediação de caixas pretas de bits no acesso às nossas representações virtuais, na qual o dono da caixa preta se isenta de responsabilidades se seu uso gerar riscos.

Temos então uma decisão a tomar. Ou promovemos a expansão do poder de propriedade para o software, ou a revertemos pela liberdade de acesso à lógica intermediadora que nos conecta ao virtual, complementando o que se deu na revolução digital a nível físico com o downsizing. Mas só teremos esta alternativa enquanto o mundo virtual ainda for considerado bem comum. Há muita gente poderosa trabalhando para tornar criminalizável o software livre, enquanto programadores que tem consciencia do seu papel social nesta revolução, e não estão nela só pelo dinheiro, estão trabalhando 60 horas por semana, para garantir seu sustento em 40 e construir os alicerces de software livre para o ciberespaço nas outras 20. Alguns dos mais importantes comandantes desta guerrilha, como os criadores da linguagem Perl, são cristãos maronitas devotos, que tomam a si parte da responsabilidade por construir um novo mundo em liberdade. Outros, como Ricard Stallman, que criou o projeto GNU e sob o qual surgiu o Linux, são ateus confessos. Mas o que os une é o senso de urgência em torno do risco que corre hoje a liberdade humana.

. A constituição americana proíbe leis de propriedade intelectual que prejudiquem o progresso das artes e ciências, então tidas com partes do bem comum, mas o congresso americano optou pela proteção irrestrita a essas caixas pretas ao permitir, com a letra da nova lei do direito autoral de 1998, que o rótulo de proteção a esses direitos se faça inquestionável em qualquer mecanismo de controle de acesso digital.

Só na semana passada, tivemos dois exemplos de risco por abuso desta proteção, no caso dos termos e condições para acesso ao Home Banking do HSBC nos EUA, (http://www.counterpane.com oct 15, 2000) e no caso do CueCat da Forbes (http://www.securityfocus.com/news/89). Deveríamos examinar o arrepio da jurisprudência sobre patentes de algoritmos e planos de negócio à leitura humanista de cláusulas constitucionais pétreas, mas o tempo não nos permite. Entretanto, por mais que este discurso seja rotulado de neobobo, o neoliberalismo contra a liberdade será puro Orwell.

Necessidades

Uma peça publicitária da maior empresa de software do mundo, reforçando sua imagem abalada por recente condenação judicial por práticas monopolistas, com seu arquiteto chefe prometendo ao público da CNN que sua nova geração de softwares irá, dentre outras maravilhas, antecipar nossas necessidades, nos dá algo para refletir. Ainda mais quando uma mudança nas expectativas de lucro desta empresa pode, em um dia, transmutá-las em ouro de 51 bilhões de dólares, como ocorrido na semana passada. Dogmas neoliberais atuam em feedback no cadinho da nova economia, sendo por isso estimuladores de ataques semânticos num ciberespaço pontilhado de velhacos.

Divisor

Em torno do divisor ideológico sobre a natureza do software na cibercultura, ocorre o debate sobre responsabilidades sociais pela sua qualidade. Hoje se discute muito se o "full disclosure" de falhas e defeitos do software é bom ou ruim. O UCITA simplesmente criminaliza a investigação que leva à descoberta de falhas, além da sua divulgação. O argumento para condená-lo é de que tal divulgação beneficia os hackers, bodes expiatórios dos pecados da virtualização. O argumento do outro lado é pragmático.

Cito Mudge, um hacker típico que passou pela fase de travessuras e hoje dirige uma empresa de segurança. Tendo estado à mesa do presidente Clinton para debater os recentes ataques de DDS, diz em entrevista como foi induzido a aderir ao full disclosure. Sua empresa passou pela fase em que falhas encontradas eram comunicadas apenas ao produtor do software, que invariavelmente se recusava a depurá-las por serem desconhecidas dos usuários: tal esforço lhe traria só despesa e nenhum lucro. Mas mesmo quando as falhas são amplamente divulgadas, alguns ainda se recusam a depurar: os riscos seriam insignificantes. Outros a reconhecer: "it's not a bug, it's a feature!". E outros a divulgar detalhes dos remendos que distribuem: é questão de segurança. Isto quando não as usam para impor novas compras a clientes.

(http://www.zdnet.com/intweek/ stories/columns/0,4164,2634819,00.html )

Esse cenário se torna ainda mais sombio quando nos deparamos com a necessidade da intermediação do software nos protocolos de assinatura digital. Onde quer que novas leis coloquem o ônus da prova de forja e de conduta cautelosa em contratos eletrônicos, ela será desequilibrada e falha se não exigir a confiabilidade dos ambientes computacionais onde operam os mecanismos autenticatórios. Estamos buscando confiança, onde o modelo de negócio de software predominante no mundo não beneficia, não privilegia, nem promove esta meta. Pelo contrário, há cada vez mais solvente na gasolina digital. Este impasse chama a atenção de pensadores na elite política americana, tais como Paul Strassman, Assistant Secretary of Defense and Director of Defense Information.("The Perverse Economics of Information" http://www.cisp.org/imp/ september_2000/09_00strassmann.htm).

A China e a França já se mobilizam para proteger o direito de acesso à lógica do software em sistemas estatais. A França e os EUA finalmente recuaram em sua política de censura à criptografia. A baderna atraída pelo FMI em Seattle, Wahington e Praga nos trazem sinais, que podem ser interpretados como aviso de que nem todos estão dispostos a trocar suas liberdades por riscos na globalização. Se estamos mesmo em meio a uma revolução, na qual as maiores violências são simbólicas, nossas escolhas profissionais nos conferem uma missão, para a qual precisamos auscultar nossa consciência e tomar posições. As revoluções tendem a ser impiedosas com os incautos e indecisos. E também com os tolos, independentemente da bondade de suas intenções.

O futuro

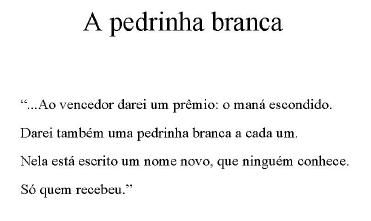

Deixando agora o pessimismo de lado, gostaria que vocês me dissessem a origem e o significado desta citação.