Introdução

A publicação

recente do artigo científico The minimal work cost of information processing

pela revista "Nature" suscitou um interessante debate numa lista de discussão sobre segurança digital, a partir da postagem do seu

resumo pelo criptógrafo e colega Anderson Nascimento. Este artigo busca registrar a contribuição do autor naquele debate, sintetizando-o.

Ao português, aquele resumo pode ser assim traduzido:

A publicação

recente do artigo científico The minimal work cost of information processing

pela revista "Nature" suscitou um interessante debate numa lista de discussão sobre segurança digital, a partir da postagem do seu

resumo pelo criptógrafo e colega Anderson Nascimento. Este artigo busca registrar a contribuição do autor naquele debate, sintetizando-o.

Ao português, aquele resumo pode ser assim traduzido:

-

"Processamento irreversível de informações não pode ser realizado sem alguns custos em termos de trabalho termodinâmico inevitável.

Esta restrição fundamental é conhecida como princípio de Landauer, que é cada vez mais relevante, posto que a dissipação de energia

de dispositivos computacionais impõe limites ao seu desempenho. Neste artigo, determinamos o mínimo de trabalho necessário para realizar

qualquer processo lógico, por exemplo um cálculo. Ele é dado pela entropia da informação descartada para condicionar a saída do cálculo.

... No plano conceitual, o nosso resultado fornece uma conexão precisa e operacional entre entropia termodinâmica e informação, e explica

o surgimento da função de estado de entropia em termodinâmica macroscópica."

Outro colega da lista lembrou que a noção de informação conforme Shannon tem origem na solução de problemas de engenharia de comunicações, e que, nessa teoria, a interpretação de entropia é "operacional". Opera através da escolha de símbolos de um alfabeto discreto, onde fonte é um conceito prático: número médio mínimo de perguntas binárias que permitem identificar a realização de uma experiência comunicável ou comunicativa qualquer. As escolhas minimais fornecem meios para se projetar códigos próprios para transmissões mínimas.

Esse aspecto da informação é entendido como sintático por desconsiderar o "sentido das mensagens", ou seja, seus possíveis aspectos subjetivos (portanto semânticos), considerando apenas sua natureza combinatória, em algum esquema de codificação. O "registro" do resultado de medidas se consolida, de forma combinatorial, em uma "memória" sem a qual não podemos sequer reconhecer mudança de estado de conhecimento entre interlocutores (aspecto semântico) em contextos específicos (aspecto pragmático). Ou seja, o aspecto sintático da informação é essencial para seus demais aspectos comunicativos (linguísticos e paralinguísticos).

Mas o moderador reitera suas dúvidas: Por que, na solução proposta, os bits podem ser entendidos como uma abstração, sem conexão com o universo físico? A independência entre os níveis sintático e semântico teria permitido sua conexão com a matemática, desligando-os da física, o que suscitou avanços nas tecnologias das comunicações (que são físicas) como a Teoria de Codificação (para correção de erros), Criptografia, Códigos para compressão, etc, os quais operam intermediariamente com sequencias de bits sem ter que considerar ou dar conta dos seus possíveis significados.

Já no nível semântico os bits se ligam a entidades da matemática ou do mundo físico, incorporando -- diferentemente do nível sintático -- valores mínimos, como "verdadeiro" e "falso" por exemplo. Em cujo caso a representação (em bits) pode estar certa ou errada com relação ao que pretende representar. Por que, ele indaga, as sucessivas mortes e exumações do demônio de Maxwell foram estudadas com bits semânticos mas passaram a valer para bits sintáticos?

Integrando níveis

De minha parte, considero que essas dúvidas surgem de uma confusão, comumente arraigada, entre os conceitos de sinal (que codifica dados), dado (que Aristóteles poderia definir como "informação em potência") e informação, cujas inter-relações -- semelhantes às das camadas na arquitetura ISO-OSI para redes -- procuro explicar diagramaticamente. "Bits sintáticos" seriam, simplesmente, dados. Mas aquele debate, talvez devido a esse arraigamento, acabou tomando outro rumo.

Entrando talvez já no nível da pragmática, considerando que a semântica pode ser vista como indissociável da pragmática para efeito de semiose (produção de significados, que inclui classificação e filtragem de ambiguidades), entendo que a incorporação de atributos binários como valor semântico de verdade/falsidade seria apenas uma das três modalidades de significação disponíveis à nossa competência cognitiva, para dar conta das diversas situações comunicativas que se apresentam aos humanos, conforme a teoria da ação comunicativa de Jurgen Habermas.

Quando buscamos algum entendimento mútuo, defende Habermas, interagimos incorporando (ou "levantando", no dizer dele) pretensões de validade (que nem sempre são aptas a representar valores 'verdadeiro'/'falso'). Mais precisamente, levantando pretensões de verdade, pretensões de correção, ou pretensões de sinceridade, conforme a natureza do enunciado: Ao nos referirmos, respectivamente, a algo objetivo no mundo das coisas, a algo intersubjetivo no mundo das relações humanas, ou a algo subjetivo no mundo da vida interior própria.

Em suma, na medida em que nós e nossos próximos também fazemos parte do mundo físico (para os ateus, dele apenas), com os seguintes tipos de proposição (enunciado sintático com valor semântico) podemos nos comunicar:

- Sobre o mundo objetivo (das coisas), levantando pretensões de verdade;

- Sobre o mundo intersubjetivo (das relações humanas), levantando pretensões de correção;

- Sobre o mundo subjetivo (dos sentimentos e crenças), levantando pretensões de sinceridade;

O que muda com a computação quântica?

A simplificação que negligencia a natureza dos sinais portadores de informação não se mostrou problemática até que começamos a lidar com portadores que estão no domínio quântico (um único fóton ou o spin de um elétron, por exemplo). Aí foi que as descrições de computação ou processamento de dados dissociados do mundo físico ficou incompleta. Nesse novo cenário, foi necessário abandonar aquelas simplificações e passar a incorporar elementos do mundo físico na sua fundamentação matemática. Depois da computação quântica não podemos mais falar em capacidade de canal, taxa máxima de compressão de dados, ou ate mesmo tese de Church-Turing, sem nos restringirmos a modelos clássicos. Em sentido amplo, temos que especificar o portador físico do sinal que codifica dados que representam informação em cada um desses casos.

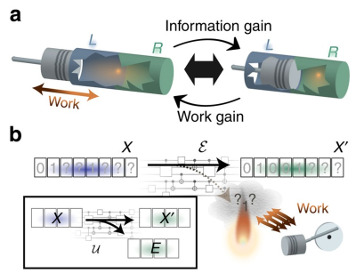

O artigo publicado na "Nature" segue essa linha. Ele atribui um modelo extremamente simples de representação física de um bit e de computação. O modelo é tão simples que parece englobar qualquer modelo físico de computação que possamos imaginar. A partir dai, utilizando as leis básicas da termodinâmica, eles obtiveram uma medida do custo (trabalho) associado a uma determinada computação. O custo é proporcional à informação que é apagada durante a computação.

O moderador prossegue, lembrando os leitores de que tudo até aqui gravitou em torno da matemática, que, em última instância, é uma atividade dos nossos neurônios. As funções de onda da física quântica são um modelo matemático que só é resolvido em situações muito especiais. Para qualquer coisa além do átomo de hidrogênio, a matriz de densidade -- base da definição de sinal quântico portador de informação -- é apenas outra abstração (de uma abstração anterior, que são as funções de onda elementares). E é apenas um modelo que na prática não é computável (no sentido de extremamente complexo). Donde a moda atual de se estudar os qubits, que são modelos matemáticos menos complexos e computacionalmente tratáveis (até certo ponto: como expressar o entrelaçamento de milhares de qubits?) O próprio qubit é uma abstração física, pois só existe na natureza por tempos ínfimos (de nano a milissegundos) e a temperaturas próximas do zero absoluto.

Por outro lado, o modelo matemático do qubit dura o tempo que for necessário dentro das mentes dos pesquisadores. Dessa forma, há tempo suficiente para os matemáticos criarem seus algoritmos, esboçarem a solução de problemas e assim por diante. Assim, os físicos estão numa corrida para conseguir alguma realização física do qubit que tenha estabilidade suficiente para atender os desejos dos matemáticos. Porém, enquanto na computação clássica o modelo matemático de Turing foi realizado como máquina física em poucos anos, e desde então, sua capacidade computacional tem crescido exponencialmente, no caso quântico, já se passaram quase 50 anos desde seu esboço inicial (talvez por Feynman), e ainda não se vê a luz do fim do túnel.

Mas a discussão aqui é outra: é em torno do consumo energético mínimo de uma computação básica, tipo xor, and, etc. Numa computação elementar clássica, entram 2 bits e sai 1 bit. Então há perda de "informação", e quando isso ocorre em dispositivos físicos há consumo de energia. E por aí vai. As dúvidas estão relacionadas à instabilidade do conceito matematizado e fisicalizado de "informação". O conceito "energia" (físico) levou uns dois séculos para se estabilizar (matematicamente). O de "informação" tem bem menos de um século e, aparentemente, ainda não se estabilizou, nem na física nem na matemática (Shannon difere de Chaitin).

Abordando as dúvidas filosoficamente

Respondendo a alguns comentários postados, Monclaro pondera que universos distintos deste (físico) não têm nada a ver com céu e inferno. Uma das interpretações da própria Mecânica Quântica (Everett) sugere universos paralelos distintos deste. E que as modelagens matemáticas da Física são de fato transitórias, mas que a Matemática e a Lógica são estáveis. Os teoremas matemáticos são eternos. A maioria dos matemáticos profissionais acreditam no chamado Realismo Matemático, ou seja, que o universo da Matemática existe por si, com o papel deles de apenas fazer descobertas. Diante de uma prova matemática correta, só existem duas posições: ou você não entende e se cala (confiando na comunidade matemática quanto a sua corretude), ou você entende e concorda. O difícil é explicar como uma coisa física (os neurônios dos matemáticos) consegue navegar fora da física, nesse outro universo, o da matemática "realista".

De minha parte, entendo que universos físicos paralelos distintos ou único, e dimensão espiritual deste ou destes universo(s) físico(s) -- onde em tese poderia haver céu e inferno --, são conceitos independentes, ortogonais até. O universo do realismo matemático é o legado de Platão sobre a natureza da mesma: o de um universo de formas e ideias perfeitas. De fato, até onde sei, cerca de 85% dos matemáticos profissionais são platonistas; porém ... a própria matemática e sua filosofia evoluíram deste Platão, embora a maioria desses matemáticos não dê importância a esta última. E evoluiu na direção de tornar a nossa compreensão de sua natureza (a da matemática) mais próxima à de outros empreendimentos sociocognitivos hoje classificados como "ciência".

A matemática e a lógica são estáveis, seus teoremas são eternos, mas nem todas suas teorias e teoremas são categóricos (na verdade, só os mais elementares parecem sê-lo): Axiomatizações alternativas para teorias como a Geometria (axiomatização euclideana ou não euclidenas), a Aritmética (com ou sem símbolo de operação multiplicativa) e a Teoria dos Conjuntos (a de Zermelo-Fraenkel + axioma da escolha, ou a de Zermelo-Fraenkel + axioma da determinação), etc, podem construir universos de formas e ideias perfeitas independentes e distintos. Onde, com uma axiomatização, a teoria produz teoremas que são falseáveis com outra axiomatização, e vice-versa, sem que nenhuma dessas axiomatizações da teoria possua elementos que nos permitam considerá-la, categoricamente, mais "correta" ou "verdadeira" ou "real" que a outra.

Diante de uma prova matemática "correta" creio que pode existir, portanto, mais de duas posições possíveis (além de calar se não entender, confiando em avaliações de corretude alheias, ou estudar e entender, para concordar). Há uma terceira opção, que, para quem privilegia a escola Formalista (em detrimento da Logicista e da Intuicionista) na Filosofia da Matemática, é legítima (e correta!): apresentar uma outra axiomatização da teoria na qual essa prova foi construída, tão admissível e verossímil quanto a primeira (com respeito a consistência e completude), na qual consiga demostrar que tal prova seja inalcançável, relativizando assim a tal prova à axiomatização subjacente (à teoria onde ela foi construída).

Difícil explicar?

Mais difícil do que explicar como os neurônios dos matemáticos conseguem navegar fora da física, nesse outro universo -- o platônico da matemática (esse navegar ocorre, a meu ver, em sede da consciência, com o veículo da competência imaginária autoreferente) --, creio que seja explicar porque e como, a partir da descoberta de paradoxos na teoria de conjuntos proposta por Georg Cantor em 1870, três escolas distintas na Filosofia da Matemática se formaram, tornando a escolha das "melhores" teorias matemáticas um assunto intersubjetivo. Ou, dito no contexto da teoria da ação comunicativa de Habermas, três escolas que inserem tal escolha num discurso público sobre pretensão de correção (a respeito do que vem a ser "verdade matemática").

O fato da verdade matemática ser um conceito que se assenta em algum conjunto de axiomas, e esses conjuntos produzirem verdades que podem ser relativas e teorias que são consistentes ou não, e de algumas dessas teorias nos servirem para modelar aspectos do "nosso" universo (como a geometria euclideana, que serviu a Newton, e a riemanniana, que eliminou da euclideana o axioma das paralelas e serviu bem a Einstein), não garante que as "boas" teorias encontrarão seu reflexo na "realidade física". Nem que as "boas" são aquelas que o encontram. Muitas teorias matemáticas supostamente consistentes e úteis ainda não encontraram os seus (as algébricas que são hoje as mais úteis à criptografia, por exemplo). E a meu ver, nunca poderão objetivamente encontrar, já que, para teorias não elementares (no sentido de poderem representar a aritmética com símbolo de operação multiplicativa, e portanto, de poderem se auto-referenciar), sua consistência e completude é indecidível em teorias cuja consistência e completude sejam internamente demonstráveis (no cálculo proposicional da lógica aristotélica clássica, por exemplo).

Este é um resultado matemático interessante, a meu ver, por iluminar uma limitação intrínseca e catégorica do intelecto humano para acesso ao suposto universo platônico. Mais interessante, entretanto, é o fato do Formalismo ser a única das três atuais abordagens filosóficas à Matemática que não precisa hierarquizar axiomatizações, nem dogmatiza o topo de hierarquia destas, assentando os seus (dogmas) na Metafísica; ou na Metamatemática, como preferem alguns discípulos de Alonzo Church (como Stephen Kleene).

O Formalismo é também a escola que deu origem a uma (nossa) teoria da computação, com Turing abstraindo a técnica que Gödel refinara de Cantor (para se manipular auto-referências em teorias matemáticas). Como computatas, portanto, ao menos por coerência devíamos privilegiar o formalismo em nossa epistemologia implícita. Onde ganha importância a metafísica (e outras "metas", se consideramos a metamatemática como distinta daquela), e onde cabe reconhecer que nosso conhecimento anda em círculos, cercado por essas limitações do intelecto humano que ele próprio, talvez por graça divina, consegue vislumbrar.